Los riesgos de seguridad que plantean los LLM y la IA generativa

Publicado por Redacción Portal ERP España en 13/01/2026 en IT SecurityLos puntos ciegos en ciberseguridad crecen con la adopción masiva de estos modelos, según Proofpoint

Fernando Anaya, country manager de Proofpoint para España y Portugal. Foto: cortesía. Portal ERP España.

La expansión de los grandes modelos de lenguaje (LLM) está transformando de forma profunda la manera en que las personas trabajan, se comunican y desarrollan procesos de innovación. Tecnologías basadas en inteligencia artificial como ChatGPT o Gemini permiten acelerar flujos de trabajo, extraer conocimiento con mayor rapidez y desplegar herramientas cada vez más sofisticadas. Sin embargo, este avance también está generando nuevos riesgos de seguridad que no siempre son evidentes para las organizaciones.

Entrenados con volúmenes masivos de datos, los LLM destacan por su capacidad para generar textos con apariencia humana y por su versatilidad en distintos casos de uso. No obstante, esta adopción creciente implica una responsabilidad adicional. Fernando Anaya, country manager de Proofpoint para España y Portugal, advierte de que “aunque esta creciente adopción conlleva también una responsabilidad”, ya que si se produce un fallo “las consecuencias pueden ser graves”, incluyendo la exposición de datos sensibles, la difusión de contenido engañoso, el incumplimiento normativo o la pérdida de confianza en los sistemas de IA.

Uno de los principales problemas es la percepción de fiabilidad de estos modelos. Los LLM pueden cometer errores, pero lo hacen de forma convincente, lo que dificulta que los usuarios cuestionen sus respuestas, especialmente cuando la dependencia de estas herramientas aumenta. Por ello, resulta clave mantener una visión crítica paralela al desarrollo de modelos cada vez más avanzados, para identificar posibles omisiones o riesgos asociados a su uso.

Te puede interesar: Proofpoint alerta del auge del phishing por códigos de dispositivo

Desde el punto de vista de la protección digital, los LLM introducen una nueva superficie de ataque. “La ciberseguridad tradicional no se diseñó pensando en los LLM, lo que abre una nueva categoría de vulnerabilidades a las que enfrentarse”, señala Anaya. A diferencia de otros sistemas, estos modelos generan lenguaje dinámico y resultados no predecibles, lo que impide aplicar mecanismos clásicos de parcheo o auditoría. Además, su funcionamiento como cajas negras complica la detección de amenazas como la inyección de instrucciones o el envenenamiento de datos.

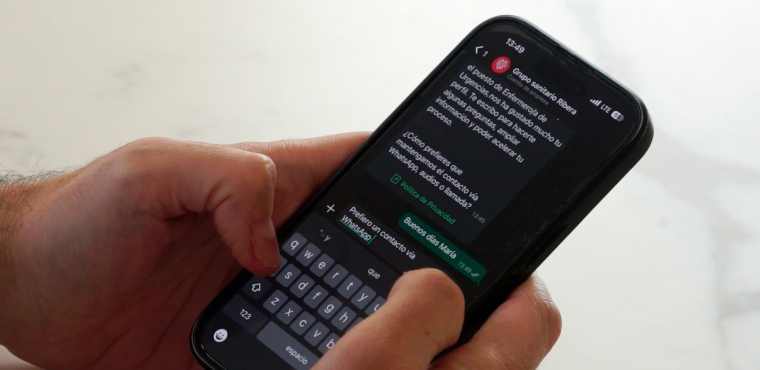

Los riesgos no se limitan a la manipulación directa de los modelos. Los atacantes pueden inferir con qué datos se ha entrenado un LLM, forzar conexiones con APIs inseguras o plugins de terceros, o incluso sobrecargar los sistemas mediante indicaciones largas y repetitivas que degraden el servicio. No obstante, el uso más extendido sigue siendo el phishing a gran escala, ya que los LLM facilitan la creación de mensajes creíbles que imitan comunicaciones legítimas para el robo de credenciales y la generación de brechas de datos.

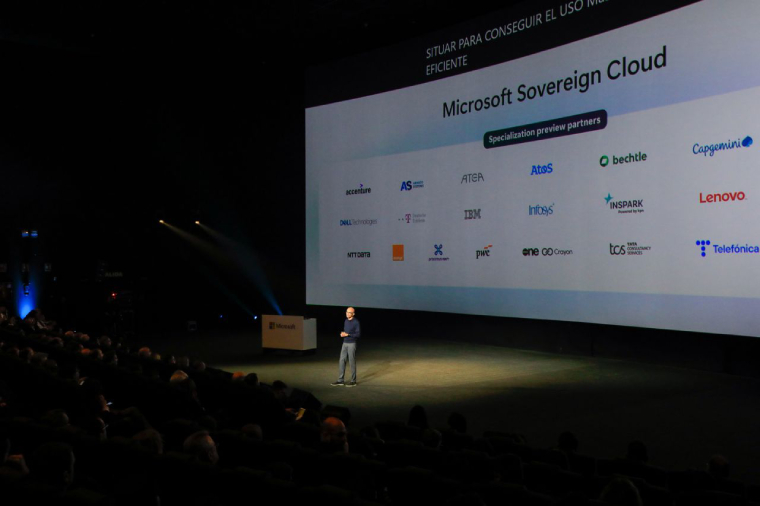

Según Anaya, el desafío es especialmente complejo porque se trata de “una tecnología que evoluciona de manera tan rápida y poderosa”, lo que exige medidas de seguridad sólidas para proteger los datos y cumplir con la normativa vigente. Esta necesidad se intensifica a medida que los LLM se integran en herramientas de uso cotidiano como Google Workspace o Microsoft 365, obligando a que las defensas se adapten al mismo ritmo para identificar posibles puntos ciegos.

Los riesgos asociados a los LLM ya se han materializado en casos reales. Uno de los más conocidos se produjo cuando ingenieros de Samsung introdujeron código fuente e información interna en ChatGPT para tareas rutinarias, lo que generó preocupación por la posible filtración de secretos comerciales y llevó a la compañía a restringir su uso y desarrollar herramientas internas. También se señala el caso de DeepSeek AI, un modelo desarrollado por una startup china que almacena datos de usuarios en servidores accesibles por el Gobierno chino, lo que plantea dudas sobre la privacidad y la seguridad de la información.

Para mitigar estos riesgos, se recomienda limitar los datos compartidos a lo estrictamente necesario y revisar siempre las respuestas generadas por los modelos. A nivel técnico, es clave aplicar controles de acceso basados en roles, personalizar las restricciones de seguridad y realizar auditorías y pruebas de penetración específicas para los riesgos de los LLM. En este contexto, Anaya subraya que “las estrategias tradicionales de seguridad de datos deben evolucionar” para incorporar mecanismos adaptativos que autentiquen a los usuarios, prevengan accesos no autorizados y evalúen continuamente cada interacción, con el objetivo de generar confianza y mantener abierto el camino hacia la innovación.